A mai bejegyzésben egy igen népszerű témához kapcsolódunk: a Nagy Nyelvi Modellekhez (Large Language Models). Egy átlagos ember számára valószínűleg a ChatGPT 3.5 megjelenése volt 2022 legnagyobb mesterséges intelligenciával kapcsolatos híre. Ebben a bejegyzésben elemezzük, hogy miben lépet előre a 3.5 modell a ChatGPT 3-hoz képest. ChatGPT A ChatGPT megjelenésével egyértelműen a figyelem középpontjába kerültek … Megerősitett Tanulás Emberi Visszajelzésből (Reinforcement Learning from Human Feedback) olvasásának folytatása

Gradiens csökkentés 2. rész — plató vs. ReLU, lokális minimum

A mai részben körbejárjuk milyen problémákkal találkozhatunk a Gradiens csökkentés során. Egyrétegű neurális hálózat Loss tere Az első részben látott példa esetén a Loss értéke konvex. Ebben az esetben elmondhatjuk, hogy ha a Lépésköz nem túl nagy, a Gradiens csökkentés előbb vagy utóbb megtalálja az optimális paramétert. Ezt fogjuk most kicsit körbejárni. Mivel a Gradiens … Gradiens csökkentés 2. rész — plató vs. ReLU, lokális minimum olvasásának folytatása

Gradiens csökkentés (aka. gradient descent) 1. rész — hogy működik

A mai bejegyzésben egy népszerű paraméter optimalizációs eljárással fogunk megismerkedni. A gradiens csökkentést gyakran alkalmazzuk neurális hálókban, így érdemes egy kis időt eltölteni a megismerésével. A probléma Tegyük fel, hogy a következő megfigyeléseink vannak: független változó (x)függő változó (y)0,51,42,31,92,93,2Megfigyelések Ezekre az adatokra szeretnénk egy lineáris modellt illeszteni. A kérdés mik lesznek az optimális paraméterei ennek … Gradiens csökkentés (aka. gradient descent) 1. rész — hogy működik olvasásának folytatása

Logisztikus regresszió 2. rész — determinációs együttható és p-érték

Az előző részben megismertük, hogy a logisztikus regressziós modell készítésének hátterét, a mai bejegyzésben megnézzük a modellünk mennyire használható. Ehhez a lineáris regresszióval kapcsolatban megismert determinációs együtthatót és p-értéket fogjuk használni. McFadden áldeteminációs együttható A McFadden ugyanazt a logikát követi mint a lineáris modell determinációs együtthatója. Vagyis a determinációs együttható a legjobb és a legrosszabb … Logisztikus regresszió 2. rész — determinációs együttható és p-érték olvasásának folytatása

Logisztikus regresszió 1. rész — modell készítése

A mai bejegyzésben egy népszerű osztályozó modellt fogunk megismerni. Alapesetben két csoport modellezésére szokták használni, de ki lehet terjeszteni több csoportra is. A logisztikai regressziót már említettem korábban a ROC görbe alatti területről szóló bejegyzés során. Ott elhangzott, hogy a kimenete annak a valószínűsége, hogy egy megfigyelés egyik vagy másik csoportba tartozik e. Hogy megértsük … Logisztikus regresszió 1. rész — modell készítése olvasásának folytatása

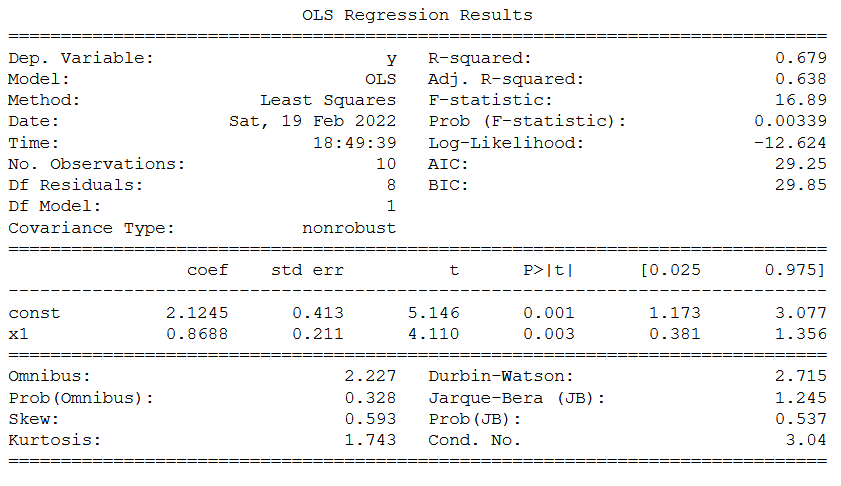

Lineáris modell determinációs együttható — statisztika alapok

A mai bejegyzésben körbejárjuk, hogyan tudjuk eldönteni két lineáris modell közül melyik jelzi előre sikeresebben az adatokat. A bejegyzésben megismerjük mi a determinációs együtható (angolul: R-squared), és hogy mire lehet használni. A Loss fügvényről szóló bejegyzésben már megemlítettük, hogy készítünk egyetlen lineáris modellt: Kipróbálunk egy rakás lineáris modellt, és a végén az kerül kiválasztásra, aminél … Lineáris modell determinációs együttható — statisztika alapok olvasásának folytatása

Véletlenszerű erdő (Random Forest)

Mai bejegyzésünkben a Döntési fa egyik továbbfejlesztését fogjuk megismerni: a Véletlenszerű Erdőt (angolul: Random Forest). A korábbi bejegyzésben említettem, hogy a Döntési fa bizonyos esetekben könnyen túlilleszthető. Ennek megakadályozására az előző bejegyzésben paraméterekkel láttuk el az algoritmust, ami magával hozza a paraméter optimalizációs problémákat. A Véletlenszerű erdő a Döntési fák túlillesztési problémáját általánosabban közelíti meg. … Véletlenszerű erdő (Random Forest) olvasásának folytatása

Döntési fa

A valószínűségi fa tipikusan statisztikai megközelítése a problémáknak. Építünk egy modellt, ismerjük az eloszlásokat és az ezeknek megfelelő valószínűségeket. De mi van , ha ez nem igaz? Ha csak megfigyeléseink vannak, akkor ismerjük, hogy mi volt a bemenet, és mi lett az eredmény de az utat, a valószínűségi fát nem. Ekkor megpróbálhatjuk az egész folyamatot … Döntési fa olvasásának folytatása

Valószínűségi fa — statisztikai alapok

A mai bejegyzésben egy egyszerű valószínűségi számításban használt ábrázolással ismerkedünk meg. Valószínűségi fa In medias res, kezdjük egy példával, hogyan is néz ki egy valószínűségi fa. Legyen egy érménk és dobjuk fel, a lehetséges eredményt így ábrázolhatjuk valószínűségi fával: A fenti ábra igazság szerint csak egy irányított körmentes gráf. Vagyis egyetlen egy irányba haladhatunk az … Valószínűségi fa — statisztikai alapok olvasásának folytatása

Auto ARIMA Pythonban

A mai bejegyzésben egy idősorokon gyakran használt modellt fogunk megismerni: az AutoRegressive Integrated Moving Average-t (ARIMA) ARIMA Az ARIMA három részből épül fel: AR: Autoregression -- ebben a részben autoregressziót végzünk az idősorunkon. I: Integrated -- deriválás ellentéte ebben az esetben MA: Moving Average -- ebben a részben egy mozgó átlaggal számolt modell hibáját használjuk … Auto ARIMA Pythonban olvasásának folytatása